Bạn đang đau đầu vì không hiểu tại sao nội dung mới đăng mãi không được index? Rất có thể website của bạn đang lãng phí Crawl Budget – ngân sách thu thập dữ liệu của Google. Đừng lo lắng, trong bài viết này, đội ngũ chuyên gia tại FOOGLESEO sẽ chỉ ra các dấu hiệu, hướng dẫn cách kiểm tra và cung cấp checklist tối ưu toàn diện để giải quyết triệt để vấn đề này, giúp Google index website của bạn nhanh hơn.

Crawl budget là gì? Khái niệm và ba thành phần cốt lõi

Crawl Budget (hay còn gọi là ngân sách thu thập dữ liệu, ngân sách cào, hoặc hạn mức thu thập dữ liệu) là lượng tài nguyên mà Googlebot phân bổ cho một website trong một khoảng thời gian nhất định (thường là một tháng). Ngân sách này quyết định số lượng URL trên website mà bot sẽ truy cập, quét và xử lý. Sau khi hết ngân sách, Googlebot sẽ tạm dừng và chuyển sang website khác.

Crawl Budget không chỉ liên quan đến các trang HTML mà còn là bất kỳ tài liệu nào mà công cụ tìm kiếm thu thập, bao gồm file JavaScript, CSS, các biến thể trang dành cho thiết bị di động, biến thể hreflang và cả file PDF.

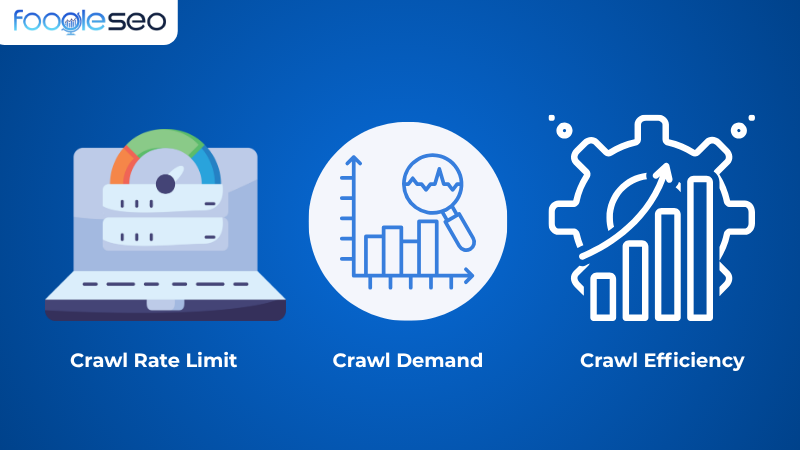

Ba yếu tố cấu thành Crawl Budget

Crawl Budget được xác định dựa trên hai yếu tố chính là Crawl Limit và Crawl Demand, ngoài ra còn có tính hiệu suất:

Crawl Rate Limit (Giới hạn tốc độ crawl)

Crawl Rate Limit (Giới hạn tốc độ crawl) là mức trần mà Googlebot có thể truy cập vào website trong một khoảng thời gian. Googlebot được thiết kế để không làm quá tải web server bằng quá nhiều yêu cầu. Nếu bot truy cập quá nhiều cùng lúc, máy chủ có thể bị quá tải, do đó Google sẽ tự điều chỉnh để tránh gây hại cho hệ thống.

Crawl Limit chịu ảnh hưởng bởi tình trạng máy chủ: nếu các URL thường xuyên hết thời gian chờ (timeout) hoặc trả về lỗi server (5xx), Crawl Limit có thể giảm xuống, khiến Googlebot thu thập dữ liệu ít thường xuyên hơn.

Crawl Demand (Nhu cầu crawl)

Crawl Demand (Nhu cầu crawl) là tần suất Google muốn thu thập dữ liệu trang web của bạn dựa trên mức độ quan trọng và phổ biến mà Google cảm nhận được. Các yếu tố ảnh hưởng đến Nhu cầu Crawl bao gồm:

- Độ phổ biến (Popularity): Những trang có nhiều backlink (liên kết từ các website khác) hoặc thu hút lưu lượng truy cập cao sẽ được Google ưu tiên thu thập dữ liệu thường xuyên hơn, vì chúng báo hiệu rằng website có thẩm quyền (Authority).

- Độ mới (Freshness): Nội dung thay đổi thường xuyên (ví dụ: website tin tức) sẽ được Googlebot ghé thăm và thu thập dữ liệu nhiều hơn.

- Thẩm quyền (PageRank/Authority): Số trang Google crawl được tỷ lệ thuận với PageRank (nay được hiểu là Page Authority/Domain Authority). Tăng thẩm quyền website là cách tốt nhất để tăng ngân sách crawl.

Crawl Efficiency (Hiệu suất crawl)

Crawl Efficiency (Hiệu suất crawl) là mức độ Googlebot tận dụng Crawl Budget để thu thập thông tin có ích. Nếu website có cấu trúc gọn gàng, tốc độ tải nhanh và ít lỗi kỹ thuật, Google sẽ dùng ngân sách crawl hiệu quả hơn, tập trung vào các trang quan trọng thay vì lãng phí vào nội dung trùng lặp hoặc không cần thiết.

Tầm quan trọng của crawl budget đối với SEO và các website lớn

Với các website lớn (TMĐT, tin tức…), quản lý crawl budget là yếu tố kỹ thuật then chốt, quyết định trực tiếp đến hiệu quả SEO. Tầm quan trọng của nó thể hiện qua 3 tác động chính:

- Ảnh hưởng trực tiếp tốc độ index: Ngân sách hạn hẹp khiến nội dung mới hoặc các cập nhật quan trọng bị Google bỏ qua, làm giảm lợi thế cạnh tranh và doanh thu.

- Quyết định khả năng hiển thị: Theo nguyên tắc Không crawl = Không index = Vô hình trên Google. Lãng phí ngân sách vào các URL rác sẽ khiến những trang quan trọng nhất của bạn không bao giờ được xếp hạng.

- Tạo ra vòng lặp hiệu suất tích cực: Tối ưu ngân sách giúp giảm tải cho server, tăng tốc độ website. Ngược lại, một website nhanh và ổn định sẽ được Googlebot ưu ái thu thập dữ liệu nhiều hơn.

Dấu hiệu nhận biết website lãng phí crawl budget

Không ít quản trị viên website vô tình làm “hao hụt” Crawl Budget. Việc phát hiện các dấu hiệu lãng phí là bước đầu tiên để tối ưu.

Lãng phí do trang trùng lặp (duplicate content) và tham số URL

Các biến thể URL từ bộ lọc sản phẩm, session ID, phân trang (pagination) hoặc các tham số URL khác (?sort=asc, ?utm_source=facebook) có thể tạo ra hàng trăm bản sao của cùng một nội dung.

Nếu không được quản lý tốt, Googlebot sẽ crawl lặp lại các trang tương tự thay vì dành ngân sách cho nội dung mới, dẫn đến lỗi trùng lặp nội dung và tiêu tốn ngân sách cào.

Chuỗi chuyển hướng (redirect chain) và lỗi truy cập (4xx, 5xx)

- Lỗi 4xx và 5xx: Các trang lỗi (404 – không tìm thấy, 5xx – lỗi server) khiến Googlebot lãng phí tài nguyên vào những URL vô ích. Tỷ lệ Crawl Error cao trong Google Search Console là một dấu hiệu rõ ràng.

- Chuỗi chuyển hướng phức tạp (Redirect Chain): Khi bot phải đi qua nhiều bước chuyển hướng (ví dụ: URL A → B → C) trước khi đến trang đích, Crawl Budget sẽ bị tiêu hao nhanh chóng. Google dường như chỉ theo dõi tối đa năm chuyển hướng trong một lần crawl.

Nội dung chất lượng thấp (Thin Content) và Orphan Pages

- Nội dung chất lượng thấp: Những trang có ít nội dung, không mang lại giá trị cho người dùng (low-quality content) dễ bị Google đánh giá thấp và làm phân tán Crawl Budget.

- Trang mồ côi (Orphan Pages): Là những trang không có liên kết nội bộ hoặc liên kết ngoài nào trỏ đến. Googlebot gặp khó khăn trong việc tìm kiếm các trang này, dẫn đến việc chúng bị bỏ quên.

Liên kết nội bộ không hợp lý và Sitemap cũ

Một cấu trúc liên kết nội bộ phức tạp hoặc vòng lặp liên kết sẽ khiến bot khó xác định ưu tiên. Ngoài ra, nếu sitemap không được cập nhật, Googlebot có thể crawl lại các trang đã xóa hoặc bỏ qua các trang mới xuất hiện, làm giảm hiệu quả index.

Hướng dẫn chi tiết cách kiểm tra ngân sách thu thập dữ liệu

Để tối ưu, trước tiên bạn cần phải đo lường, đây là bước quan trọng nhất. Dưới đây là hai phương pháp từ cơ bản đến nâng cao để bạn có được cái nhìn toàn diện về cách Googlebot đang tương tác với website của mình.

Phương pháp cơ bản: Khai thác báo cáo Crawl Stats trong Google Search Console

Đây là công cụ chính thức, miễn phí và đáng tin cậy nhất mà bạn phải thành thạo. Nó cung cấp một bức tranh tổng quan về hoạt động thu thập dữ liệu của Google trên trang của bạn trong 90 ngày qua.

Cách truy cập báo cáo

- Đăng nhập vào Google Search Console.

- Chọn website bạn muốn kiểm tra.

- Vào menu bên trái, kéo xuống và chọn Cài đặt (Settings).

- Trong trang Cài đặt, tìm và nhấp vào Mở báo cáo (Open report) bên cạnh mục Thống kê thu thập dữ liệu (Crawl stats).

Cách đọc các chỉ số quan trọng

- Tổng số yêu cầu thu thập dữ liệu (Total crawl requests): Biểu đồ này cho thấy “mức độ quan tâm” của Google. Nếu bạn thấy biểu đồ đột ngột giảm mạnh, đó là dấu hiệu của một vấn đề kỹ thuật nghiêm trọng.

- Thời gian phản hồi trung bình (Average response time): Đây là chỉ số đo “sức khỏe” máy chủ. Nếu thời gian này liên tục tăng cao, website của bạn đang chậm đi, điều này trực tiếp làm giảm Crawl Budget.

- Phân tích theo phản hồi (By response): Đây là khu vực quan trọng nhất để phát hiện lãng phí!

- OK (200): Tỷ lệ cao là tốt, nhưng câu hỏi là Google có đang crawl đúng những trang quan trọng không?

- Not found (404): Tỷ lệ này cao là một báo động đỏ. Nó cho thấy Googlebot đang lãng phí tài nguyên vào những URL không còn tồn tại.

- Server error (5xx): Bất kỳ tỷ lệ nào cao hơn 0% đều là vấn đề cần khắc phục ngay lập tức. Lỗi máy chủ sẽ khiến Googlebot giảm tần suất thu thập dữ liệu.

- Moved (301/302): Một tỷ lệ nhỏ là bình thường, nhưng nếu quá cao, có thể bạn đang có nhiều chuỗi chuyển hướng phức tạp.

- Phân tích theo mục đích (By purpose):

- Refresh: Google thu thập lại các URL đã biết.

- Discovery: Google tìm thấy các URL hoàn toàn mới. Nếu tỷ lệ Discovery quá thấp, điều đó có nghĩa là Google đang gặp khó khăn trong việc tìm thấy nội dung mới của bạn.

Phương pháp nâng cao: Phân tích log file server để mở khóa dữ liệu gốc

Nếu Google Search Console cung cấp cho bạn một bản báo cáo tóm tắt đã qua xử lý, thì Phân tích tệp nhật ký (Log File Analysis) giống như việc bạn đọc dữ liệu từ chính hộp đen của máy chủ. Đây là phương pháp tối thượng cung cấp dữ liệu thô, không qua bộ lọc, ghi lại từng hành động nhỏ nhất của Googlebot trên website của bạn.

Đối với các chuyên gia SEO kỹ thuật, đây là nguồn dữ liệu chân thật nhất để hiểu sâu về mối quan hệ giữa máy chủ và các trình thu thập dữ liệu.

Những thông tin chỉ có thể tìm thấy qua Log File

- Tần suất thu thập dữ liệu chính xác trên từng URL: Bạn sẽ biết chính xác trang sản phẩm chủ lực được Googlebot ghé thăm 5 lần/ngày trong khi trang danh mục quan trọng chỉ được ghé thăm 1 lần/tuần. Dữ liệu này giúp bạn điều chỉnh lại chiến lược liên kết nội bộ (internal linking).

- Phát hiện các URL “ngốn” ngân sách nhất: Log file sẽ chỉ ra chính xác Googlebot đang lãng phí bao nhiêu phần trăm ngân sách vào các URL vô giá trị do bộ lọc đa danh mục (faceted navigation) hoặc các tham số URL (URL parameters) tạo ra.

- Xác thực danh tính Googlebot: Nhiều bot xấu thường giả mạo User-Agent của Googlebot để cào dữ liệu. Phân tích log file cho phép bạn thực hiện tra cứu DNS ngược (reverse DNS lookup) trên địa chỉ IP của trình thu thập, xác minh chắc chắn đó có phải là Googlebot thật hay không.

- Ưu tiên thu thập thực tế của Google: Báo cáo cho thấy rõ Googlebot đang dành nhiều thời gian hơn cho thư mục /blog/ hay /san-pham/. Từ đó, bạn biết được Google đang đánh giá cao loại nội dung nào trên trang của bạn.

- Phát hiện lỗi ngay lập tức: Bạn có thể thấy ngay lập tức các đợt tăng đột biến của mã trạng thái HTTP như 404 (Không tìm thấy) hoặc 5xx (Lỗi máy chủ) mà không cần chờ GSC cập nhật.

Việc phân tích log file là một công việc phức tạp, đòi hỏi sự phối hợp giữa SEO Specialist và Developer. Nó thường cần đến các công cụ chuyên dụng như Screaming Frog Log File Analyser, Splunk, hoặc các hệ thống quản lý log khác. Để tiết kiệm thời gian và đảm bảo độ chính xác, nhiều doanh nghiệp lựa chọn giải pháp chuyên nghiệp. Bạn có thể tham khảo giá dịch vụ SEO web của chúng tôi để có sự hỗ trợ từ các chuyên gia.

Checklist 9+ chiến lược tối ưu Crawl Budget toàn diện

Hãy bắt tay vào hành động với checklist chi tiết dưới đây! Việc tối ưu Crawl Budget là một phần không thể thiếu trong bất kỳ một technical SEO checklist toàn diện nào.

Nền tảng kỹ thuật – Xây móng vững chắc

- Tăng tốc độ tải trang (Page Speed & Core Web Vitals): Website càng nhanh, Googlebot càng thu thập được nhiều trang trong cùng một khoảng thời gian. Hãy tối ưu hình ảnh, CSS, JavaScript và sử dụng hosting chất lượng.

- Giữ cho máy chủ “khỏe mạnh” (Giảm lỗi 5xx): Lỗi máy chủ là “đèn đỏ” đối với Googlebot. Hãy làm việc với đội ngũ kỹ thuật để đảm bảo uptime của server luôn ở mức cao nhất.

Điều hướng Googlebot thông minh

- Tối ưu file Robots.txt: Chặn các URL không cần thiết (trang quản trị, trang kết quả tìm kiếm nội bộ, trang giỏ hàng…) để Googlebot tập trung vào nội dung quan trọng.

- Sử dụng Sitemap.xml như một tấm bản đồ tin cậy: Đảm bảo sitemap của bạn luôn được cập nhật, chỉ chứa các URL quan trọng (có status 200) và đã được khai báo trong Google Search Console.

- Xử lý triệt để URL Parameters và Faceted Navigation: Các bộ lọc (theo giá, màu sắc, kích thước…) có thể tạo ra vô số URL trùng lặp. Sử dụng công cụ URL Parameters trong GSC và thẻ rel=”canonical” để giải quyết.

- Dọn dẹp chuỗi Redirects (301): Một chuỗi chuyển hướng (A -> B -> C) sẽ làm tiêu tốn ngân sách. Hãy tối ưu để chuyển hướng trực tiếp (A -> C).

Tối ưu cấu trúc và nội dung

- Xây dựng cấu trúc Internal Linking logic: Các trang quan trọng nhất nên nhận được nhiều liên kết nội bộ từ các trang khác. Điều này báo hiệu cho Google về tầm quan trọng của chúng.

- Loại bỏ “bóng ma” Duplicate Content: Sử dụng thẻ Canonical để chỉ định đâu là URL gốc, tránh việc Googlebot lãng phí thời gian thu thập nhiều phiên bản của cùng một nội dung.

- Sử dụng “Noindex” một cách chiến lược: Đối với các trang không có giá trị SEO (chính sách bảo mật, trang cảm ơn, trang tag mỏng nội dung…), hãy mạnh dạn sử dụng thẻ noindex.

- Cải thiện chất lượng và độ tươi mới của nội dung: Nội dung chất lượng cao, được cập nhật thường xuyên sẽ thu hút Googlebot quay trở lại.

Câu hỏi thường gặp (FAQs)

Kết luận

Việc làm chủ Crawl Budget không chỉ là một kỹ thuật SEO, mà là một lợi thế cạnh tranh chiến lược, đảm bảo mọi tài nguyên giá trị của website đều được Google ghi nhận. Bài viết đã cung cấp cho bạn một lộ trình toàn diện từ chẩn đoán đến tối ưu. Nếu bạn cần một đối tác chuyên nghiệp để thực thi, hãy liên hệ với FOOGLESEO ngay hôm nay để được tư vấn và triển khai một cách hiệu quả nhất!